Un petit résumé de l’histoire de l’ordinateur

J’ai décidé de remettre en ligne cet article, qui avait disparu avec l’ancienne version du site (comme tous les articles de cette version en même temps…), car en navigant sur Google, j’ai découvert qu’il servait de référence à un article de la célèbre encyclopédie en ligne, Wikipédia.

J’en profite pour réécrire l’article. Il contiendra les mêmes infos plus quelques unes que je rajouterais pour le compléter.

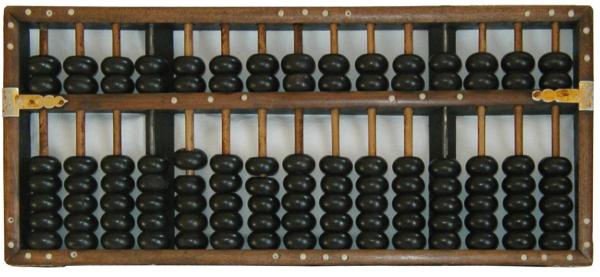

Tout commence avec le boulier (un type d’abaque). Cette invention, la machine à calculer, très utilisée par les chinois en 500 av. J.-C. était déjà utilisée par les babyloniens en 3000 av. J.-C.. Il permettait de réaliser des additions, soustraction, multiplications et divisions.

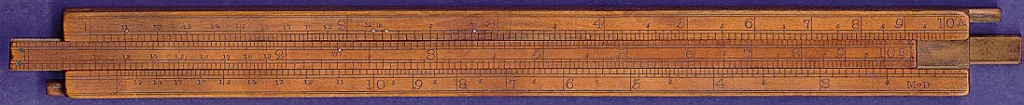

Les logarithmes, inventés en 1614 par l’écossais John Neper (1550-1617) permirent, en 1620, l’invention de la règle à calcul par William Oughtred (1574-1660). Cette règle permet, de manière analogique, d’effectuer des multiplications, des divisions, et des opération plus complexes telle que les racines (carrées et cubiques), les calculs trigonométriques… Cette règle a été utilisé jusque dans les années 70 par les scientifiques.

Wilhelm Schickard (1592-1635) inventa la première machine à calculer en 1623. L’horloge à calculer permettait les additions et les soustractions. Elle fut détruite dans un incendie.

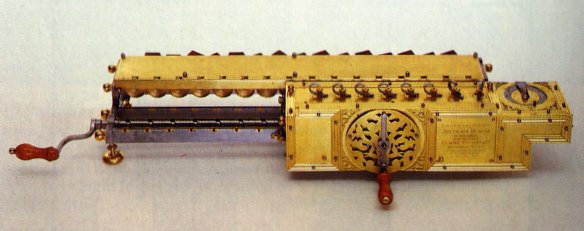

Blaise Pascal (1623-1662), pour aider son père percepteur des impôts, invente en 1642, la Pascaline, une machine permettant les additions et les soustractions.

Gottfried Wilhem Leibniz (1646-1716) dériva en 1673 la Pascaline en lui ajoutant la multiplication et la division.

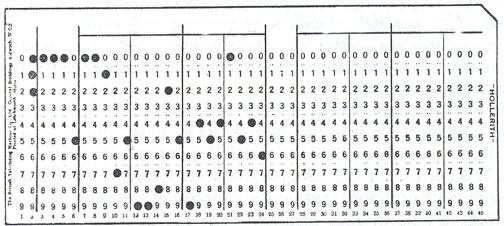

En 1728, Jean-Baptiste Falcon invente la carte perforée, qu’il utilises dans ses machines à tisser.

Charles Xavier Thomas de Colmar (1785-1870) crée l’arithmomètre en utilisant comme base la machine Leibniz en 1822. Cette machine facile d’utilisation et portable, première calculatrice, sera commercialisée à 1500 exemplaires en 30 ans. C’est un grand succès.

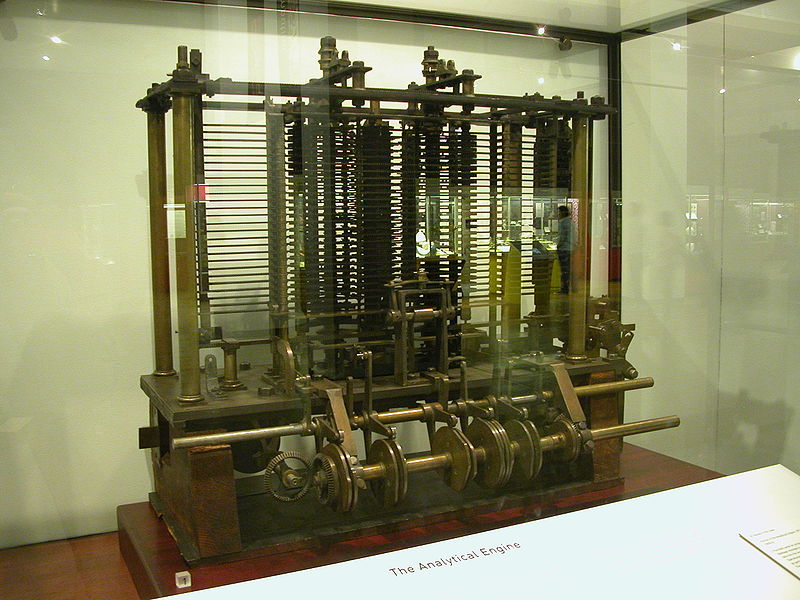

Charles Babbage (1792-1871) se lance en 1834 dans le projet de la machine analytique. Cette machine, partiellement réalisée, permet l’approximations de fonctions. Elle réutilise le principe des cartes perforées du métier de Joseph-Marie Jacquard (1752-1834) (basée sur les cartes de Jean-Baptiste Falcon) pour spécifier le type d’opérations et localiser l’opérande au sein de la mémoire. Un deuxième jeu de cartes perforées servait quant à lui à entrer les données dans la machine. Charles Baddage a été le premier à énoncer le principe de l’ordinateur.

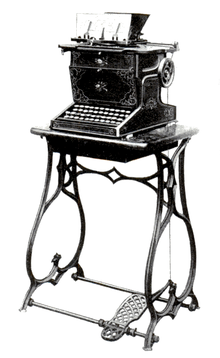

La première machine à écrire QWERTY, la machine à écrire Sholes et Glidden ( ou Remington No. 1), est inventée en 1867 par Christopher Latham Sholes (1819-1890). Elle obtint un succès commercial suite à sa mise sur le marché en 1874.

La première carte perforée moderne a été inventée en 1890 par Herman Hollerith (1860-1929). Toujours inspirée du métier Jacquard, il l’utilise dans une machine de son invention, une tabulatrice électromécanique, pour effectuer le recensement des américains. Il fonde en 1896 la firme Tabulating Machine Corporation, renommée en 1924 en International Business Machine (IBM).

L’évolution remarquable que les mathématiques connurent jusqu’à la Seconde Guerre Mondiale ainsi que l’invention du premier tube à vide (la diode) par John Fleming en 1904, permirent de faire naître rapidement l’ordinateur électronique.

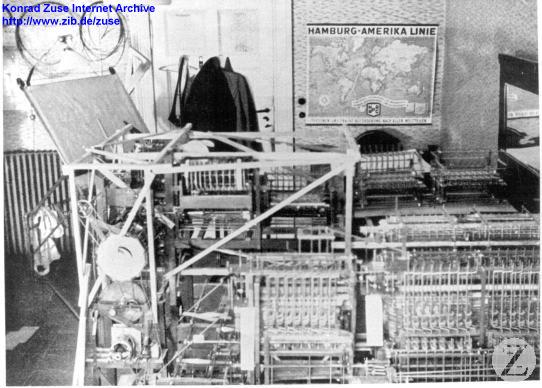

Le Z1, premier ordinateur mécanique programmable, est créé en 1938 par Konrad Zuse (1910-1995). Sa conception fût réalisée dans le salon des parents de Zuse ;).

En 1943, Howard H. Aiken (1900-1973) crée pour IBM, l’ASCC (Automatic Sequence-Controlled Calculator), renommé en Mark I par l’université d’Harvard. Ce petit calculateur électromécanique (3000 relais, 760000 pièces mécaniques, 800 km de câbles, cinq tonnes, occupant 25 mètres carrés) est le premier ordinateur entièrement automatique. Il permet de réaliser 3 opérations sur 23 chiffres par secondes et sauvegarder 72 nombres de 23 chiffres. Sa conception est très proche de la machine analytique de Baddage.

John Atanasoof et Clifford Berry construisirent l’ABC (Atanasoff-Berry Computer), le premier calculateur binaire à lampes. Cet ordinateur est le premier à utiliser l’algèbre de Boole. Cette machine, composée de 210 lampes, d’une mémoire et de circuits logiques, tournait à 60Hz et pouvait réaliser une addition par secondes. Sa mémoire est constitué de 2 tambours pouvant, à eux deux, 60 mots de 50 bits.

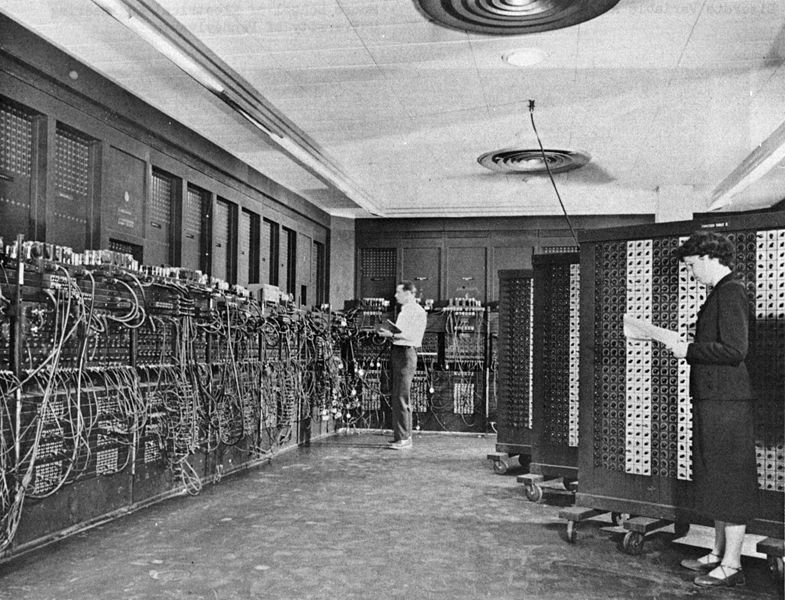

John William Mauchly (1907-1980) et John Eckert (1919-1995) mirent au point l’ENIAC en 1946, le premier calculateur électronique. Cadencé à 100 kHz, il permettait de faire 330 multiplications par seconde. Il servit à la conception de la bombe H.

John Bardeen, Walter Brattain et William Shockley obtinrent le prix Nobel de physique en 1956 pour l’invention en 1947, du transistor bipolaire à jonction. Cette invention marqua un tournant dans l’histoire de l’ordinateur.

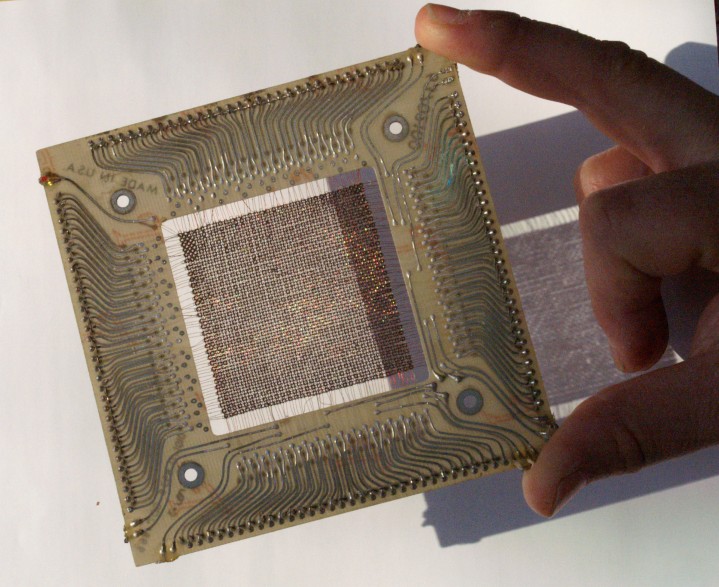

En 1953 est inventée la mémoire à tores de ferrite qui remplacera les anciens systèmes, tous moins fiables que ce nouveau type de mémoire.

En 1959, l’invention des circuits intégrés par John Kilby et Robert Noyle permis la miniaturisation des ordinateurs (restant quand même encombrants :P).

S’en suit la création de plusieurs ordinateurs à transistors, de tailles et puissances diverses et variées, utilisant différents types de mémoire (tores de ferrite, disques durs…).

En 1971 naquit le premier microprocesseur, créé par Ted Hoff et Federico Faggin pour le compte d’Intel au doux nom d’Intel 4004. Ce processeur 4 bits composé de 2300 transistors permet 60000 opérations par seconde.

S’en suivent ensuite la sortie des premiers micro-ordinateurs dans le années 70, tel que le Micral en 1973, un micro-ordinateur équipé du processeur Intel 8008 (processeur comercialisé en 1972).

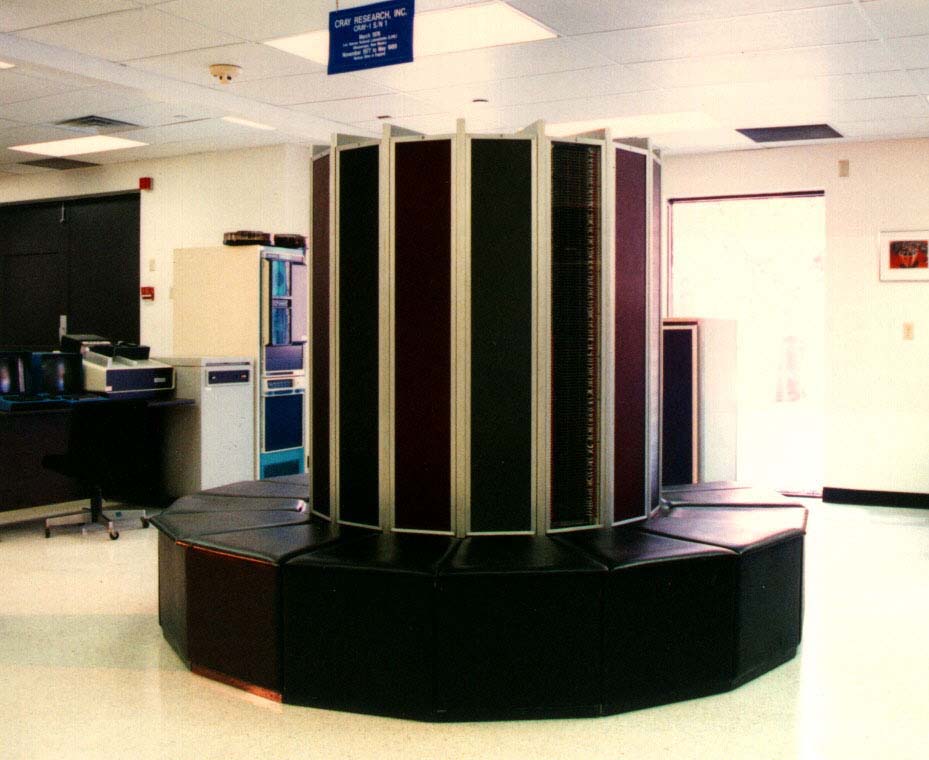

Toujours durant les années 70, apparurent aussi les premiers super-ordinateurs comme le CRAY-1en, conçu par Seymour Cray en 1976. Cet ordinateur pouvait exécuter 160 millions d’opérations par seconde.

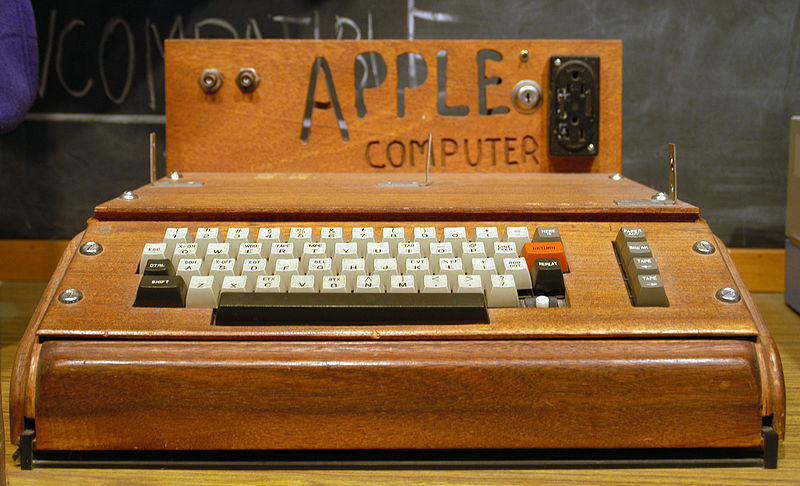

C’est en 1976 aussi que naquit Microsoft, créée par Paul Allen et Bill Gates, et Apple, créée par Steve Jobs et Steve Wozniak. La même année, Apple commercialise le premier micro-ordinateur personnel, l’Apple I.

Le premier virus informatique voit le jour en 1981. Ce nom est dû à Leonard Adleman.

Depuis les années 80, les ordinateurs n’ont cessé d’évoluer pour devenir ce qu’ils sont aujourd’hui. Retracer ces évolutions est difficile du fait qu’elles sont très nombreuses et continueront d’augmenter dans les futures années. Le premier micro-processeur en 1971, l’Intel 4004, contenait 2300 transistors, l’Intel Core i7 sorti en 2008, en contient 2,27 milliards en 2012. On voit bien que cette évolution suit la loi de Moore :

« On peut placer quatre fois plus de transistors sur une puce tous les trois ans. »

Si l’évolution continu comme ça, en 2020 les processeurs contiendront plus de 25 milliards de transistors…

To be continued…

Sources :

- Université Bordeaux

- Lieux Dits

- Beaucoup d’articles de Wikipédia